O arquivo robots.txt é como um guia para mecanismos de busca, como o Google, indicando quais partes do seu site podem ser exploradas e quais devem ser ignoradas.

Ele ajuda a direcionar a atenção dos mecanismos de busca para as páginas que você quer destacar, ao mesmo tempo que ajuda a proteger áreas sensíveis ou privadas do site.

Índice

O que é robots.txt?

O arquivo robots.txt é um arquivo de texto simples que instrui os robôs dos mecanismos de busca sobre quais páginas ou seções de seu site devem ou não ser rastreadas e indexadas.

Ele age como um tipo de “porteiro” para o site, direcionando o tráfego de bots de acordo com regras estipuladas.

Como criar um arquivo robots.txt?

Criar um arquivo robots.txt é bastante simples. Você só precisa de um editor de texto como o Bloco de Notas ou TextEdit e seguir a sintaxe específica para as instruções. Por exemplo:

User-agent: *

Disallow: /privado/A instrução User-agent: * Disallow: /privado/ indica que todos os robôs de busca (representados por *) estão proibidos de acessar ou indexar o diretório /privado/ do site. Isso significa que o conteúdo dentro dessa pasta não será rastreado pelos mecanismos de busca, mantendo-o fora dos resultados de pesquisa.

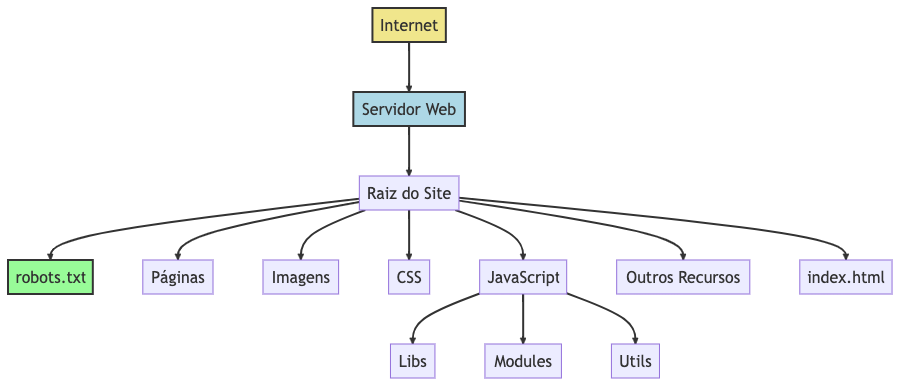

Onde colocar o arquivo robots.txt?

O arquivo deve ser colocado na raiz do domínio do seu site. Por exemplo, se o seu site é www.exemplo.com, o arquivo deve estar disponível em www.exemplo.com/robots.txt.

Como bloquear ou permitir bots?

Para bloquear todos os bots de rastrear qualquer parte do seu site, você usaria:

User-agent: *

Disallow: /Para permitir o acesso completo, você usaria:

User-agent: *

Disallow:Como desabilitar o bot da OpenAi (ChatGPT)?

Para impedir que o GPTBot acesse seu site, você pode adicionar o GPTBot ao arquivo robots.txt do seu site:

User-agent: GPTBot

Disallow: /Para permitir que o GPTBot acesse apenas partes do seu site, você pode adicionar o token do GPTBot ao arquivo robots.txt do seu site da seguinte forma:

User-agent: GPTBot

Allow: /pasta-1/

Disallow: /pasta-2/Sintaxe e Comandos

Os principais comandos são User-agent para especificar o bot e Disallow para especificar as páginas a serem bloqueadas. Você também pode usar Allow para permitir o acesso a páginas específicas.

Obs: O comando Allow não faz parte oficialmente das especificações do robots.txt, mas os principais mecanismos de busca o respeitam. No entanto, ele é redundante, pois tudo o que não é explicitamente bloqueado já está permitido para ser rastreado.

Aqui estão algumas das principais sintaxes e comandos que você pode usar em um arquivo robots.txt:

Comandos Básicos

- User-agent: Especifica o robô da web ao qual as regras se aplicam.

- Exemplo:

User-agent: Googlebot

- Exemplo:

- Disallow: Impede que robôs acessem determinadas partes do site.

- Exemplo:

Disallow: /privado/

- Exemplo:

- Allow: Permite que robôs acessem determinadas partes do site, mesmo que uma regra

Disallowmais ampla exista.- Exemplo:

Allow: /publico/

- Exemplo:

Sintaxes Básicas

- Coringa (*): Representa qualquer sequência de caracteres.

- Exemplo:

Disallow: /*.jpg$

- Exemplo:

- Dólar ($): Indica o fim de uma URL.

- Exemplo:

Disallow: /*.php$

- Exemplo:

- Comentários (#): Qualquer coisa após o símbolo

#em uma linha é um comentário.- Exemplo:

# Este é um comentário

- Exemplo:

- Sitemap: Fornece a localização do arquivo XML do sitemap.

- Exemplo:

Sitemap: http://www.exemplo.com/sitemap.xml

- Exemplo:

O robots.txt é obrigatório?

Ter um arquivo robots.txt não é obrigatório, mas é altamente recomendado para controlar o acesso dos bots e melhorar o SEO.

Impacto no SEO

Um arquivo robots.txt bem configurado pode melhorar o SEO ao evitar que os mecanismos de busca indexem conteúdo duplicado ou irrelevante.

Além disto, robots.txt pode ser um aliado para contornar e evitar problemas relacionados com crawl budget.

Isto será especialmente útil em sites muito grandes (aqueles com mais de um milhão de páginas únicas) e com conteúdo que muda com frequência moderada (uma vez por semana).

Ferramentas e Validadores

Existem várias ferramentas online, como o “Robots.txt Tester” do Google, que podem ajudá-lo a validar a sintaxe do seu arquivo.

Outros Exemplos e Modelos

Aqui estão alguns exemplos:

WordPress:

# Define as regras para todos os robôs de busca

User-Agent: *

# Não desabilita nenhum diretório ou arquivo, permitindo que todos sejam indexados

Disallow:

# Especifica o local do arquivo sitemap para ajudar os robôs a encontrar todas as páginas

Sitemap: https://www.exemplo.com/sitemap_index.xmlMagento:

User-agent: *

# Estes comandos impedirão que os robôs indexem os diretórios do sistema Magento

Disallow: /app/

Disallow: /bin/

Disallow: /dev/

Disallow: /lib/

Disallow: /phpserver/

Disallow: /pkginfo/

Disallow: /report/

Disallow: /setup/

Disallow: /update/

Disallow: /var/

Disallow: /vendor/

# Estes comandos impedirão que os robôs indexem arquivos do sistema presentes na raiz do Magento

Disallow: /composer.json

Disallow: /composer.lock

Disallow: /CONTRIBUTING.md

Disallow: /CONTRIBUTOR_LICENSE_AGREEMENT.html

Disallow: /COPYING.txt

Disallow: /Gruntfile.js

Disallow: /LICENSE.txt

Disallow: /LICENSE_AFL.txt

Disallow: /nginx.conf.sample

Disallow: /package.json

Disallow: /php.ini.sample

Disallow: /RELEASE_NOTES.txt

# Estes comandos impedirão que os robôs indexem URLs do sistema

Disallow: /index.php/

Disallow: /catalog/product_compare/

Disallow: /catalog/category/view/

Disallow: /catalog/product/view/

Disallow: /catalogsearch/

Disallow: /checkoutSegurança

É importante notar que o arquivo robots.txt não é uma medida de segurança. Informações sensíveis devem ser protegidas por outros métodos, como autenticação.

Conclusão

Em resumo, o arquivo robots.txt é uma ferramenta simples, mas poderosa, para gerenciar como os mecanismos de busca interagem com o seu site.

Ele permite que você especifique quais áreas do site devem ser acessíveis e quais devem ser mantidas fora do alcance.

Isso não apenas melhora a eficiência dos mecanismos de busca ao explorar seu site, mas também ajuda a manter informações que você não quer que sejam públicas fora do alcance dos bots.

Com um arquivo robots.txt bem configurado, você tem mais controle sobre a visibilidade do seu site na internet.

Publicado originalmente em 27/08/2023 | Última atualização em 29/09/2024