O arquivo robots.txt é como um guia para mecanismos de busca, como o Google, indicando quais partes do seu site podem ser exploradas e quais devem ser ignoradas.

Ele ajuda a direcionar a atenção dos mecanismos de busca para as páginas que você quer destacar, ao mesmo tempo que ajuda a proteger áreas sensíveis ou privadas do site.

Índice

O que é robots.txt?

O arquivo robots.txt é um arquivo de texto simples que instrui os robôs dos mecanismos de busca sobre quais páginas ou seções de seu site devem ou não ser rastreadas e indexadas.

Ele age como um tipo de “porteiro” para o site, direcionando o tráfego de bots de acordo com regras estipuladas.

Qual o impacto do robots.txt no SEO?

Um arquivo robots.txt bem configurado é fundamental para a saúde do SEO Técnico, pois impede que os robôs desperdicem recursos rastreando páginas irrelevantes, scripts de sistema ou conteúdo duplicado gerado por filtros de URL.

O seu principal benefício é a otimização do Crawl Budget (orçamento de rastreamento). Ao bloquear áreas de baixo valor, você direciona o Googlebot para priorizar o que realmente importa: suas páginas de conteúdo e produtos.

Essa gestão é crítica para sites de grande porte (acima de 1 milhão de URLs) ou portais com atualização frequente, garantindo que novas páginas sejam descobertas e atualizadas mais rapidamente.

Como criar um arquivo robots.txt?

Criar um arquivo robots.txt é bastante simples. Você só precisa de um editor de texto como o Bloco de Notas ou TextEdit e seguir a sintaxe específica para as instruções. Por exemplo:

User-agent: *

Disallow: /privado/A instrução User-agent: * Disallow: /privado/ indica que todos os robôs de busca (representados por *) estão proibidos de acessaro o diretório /privado/ do site.

Isso significa que o conteúdo dentro dessa pasta não será rastreado pelos mecanismos de busca, mantendo-o fora dos resultados de pesquisa.

Atenção: bloquear rastreamento não garante a não-indexação

É fundamental entender uma distinção técnica: o robots.txt impede o rastreamento (leitura do conteúdo), mas não impede necessariamente a indexação (aparição no Google).

Se você bloquear uma página no robots.txt (Disallow), o Googlebot não lerá o que está nela. Porém, se outros sites apontarem links para essa página, o Google ainda poderá indexar a URL e exibi-la nos resultados de pesquisa (geralmente sem a descrição/snippet).

Como remover uma página do Google com certeza?

Para garantir que uma página não apareça nos resultados, não use o robots.txt. Em vez disso:

- Permita o rastreamento da página no robots.txt (para que o robô possa acessá-la).

- Adicione a meta tag noindex no código HTML da página (<meta name=”robots” content=”noindex”>).

Desta forma, o robô entra, lê a instrução de “não indexar” e remove a página do índice. O robots.txt serve para poupar recursos do servidor e gerenciar o Crawl Budget, não para ocultar conteúdo sensível.

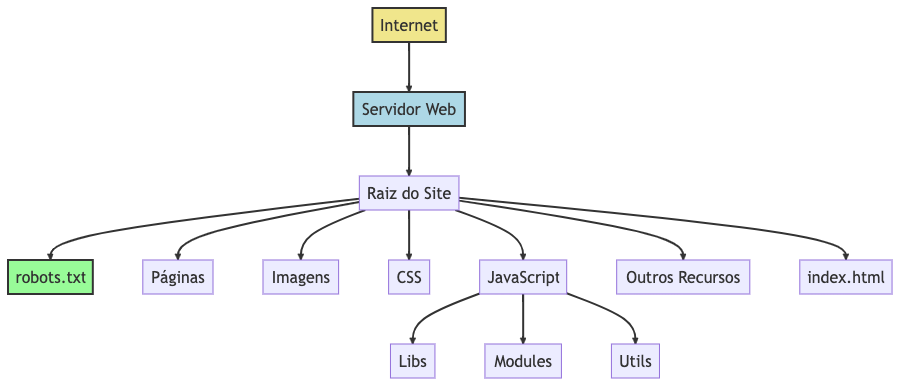

Onde colocar o arquivo robots.txt?

O arquivo deve ser colocado na raiz do domínio do seu site. Por exemplo, se o seu site é www.exemplo.com, o arquivo deve estar disponível em www.exemplo.com/robots.txt.

Como bloquear bots?

Para bloquear todos os bots de rastrear qualquer parte do seu site, você usaria:

User-agent: *

Disallow: /Bots de IA e a Era do GEO

Estratégia para IAs: Bloquear ou Permitir? (O conceito de GEO)

Com a ascensão dos motores de resposta baseados em Inteligência Artificial, surgiu o conceito de GEO (Generative Engine Optimization). Diferente do SEO tradicional, o foco aqui é garantir que seu conteúdo seja lido, compreendido e citado como fonte pelas IAs.

A Recomendação Atual: Permita o Acesso

Para a maioria dos sites que buscam tráfego e autoridade, a recomendação atual é permitir o acesso dos bots de IA.

Se você bloquear bots como o OAI-SearchBot (da OpenAI) ou o Google-Extended, as ferramentas de IA não conseguirão ler seu conteúdo atualizado.

O resultado? Seu concorrente será citado na resposta, e você não.

Se o seu objetivo é visibilidade, certifique-se de que seu robots.txt não está bloqueando estes agentes.

Como garantir o acesso (Exemplos de Configuração)

Como falei, por padrão, o robots.txt já permite tudo o que não está bloqueado. Você não precisa adicionar linhas de “Allow” se não tiver bloqueios anteriores.

No entanto, se você quiser ser explícito ou garantir que não está bloqueando por engano, verifique se NÃO existem regras como estas:

# EVITE fazer isso se você quer aparecer no SearchGPT ou Perplexity:

User-agent: GPTBot

Disallow: /

User-agent: ChatGPT-User

Disallow: /

User-agent: CCBot

Disallow: /O Caminho do Meio: Permitir Pesquisa, Bloquear Treino

Algumas empresas (como a OpenAI) começaram a separar os bots de “Treino” (criar o modelo) dos bots de “Pesquisa” (buscar informação em tempo real).

Se você quer tráfego do SearchGPT, mas não quer que seu texto treine o GPT-5, você pode usar esta configuração híbrida:

# 1. Permite o bot de PESQUISA (Essencial para tráfego/GEO)

User-agent: OAI-SearchBot

Allow: /

# 2. Bloqueia o bot de TREINO (Opcional - protege propriedade intelectual)

User-agent: GPTBot

Disallow: /

Resumo para SEO/GEO:

Em um cenário onde as pessoas usam cada vez mais o chat para buscar informações, o acesso dos bots é a porta de entrada para o tráfego.

Bloqueie apenas se o seu conteúdo for confidencial ou se você tiver uma razão jurídica específica para não alimentar modelos de IA.

Como desabilitar o bot da OpenAi (ChatGPT)?

Para impedir que o GPTBot acesse seu site, você pode adicionar o GPTBot ao arquivo robots.txt do seu site:

# Bloqueia o uso do conteúdo para treinar futuros modelos (GPT-5, etc)

User-agent: GPTBot

Disallow: /

# (Opcional) Bloqueia a exibição do site no SearchGPT (Mecanismo de busca)

User-agent: OAI-SearchBot

Disallow: /

# (Opcional) Bloqueia plugins e navegação direta de usuários do ChatGPT

User-agent: ChatGPT-User

Disallow: /Para permitir que o GPTBot acesse apenas partes do seu site, você pode adicionar o token do GPTBot ao arquivo robots.txt do seu site da seguinte forma:

User-agent: GPTBot

Allow: /pasta-1/

Disallow: /pasta-2/Google (Gemini e Vertex AI)

Muitos administradores temem bloquear o Googlebot e sumir da pesquisa do Google. Para evitar isso, o Google criou um agente específico que controla apenas o uso de dados para IA, sem afetar o SEO tradicional.

# Bloqueia o uso de dados para o Gemini e Vertex AI

# Seu site CONTINUA aparecendo na pesquisa do Google normalmente.

User-agent: Google-Extended

Disallow: /Anthropic (Claude) e Apple

Outros modelos importantes que consomem muitos dados:

# Bloqueia o bot da Anthropic (Claude)

User-agent: ClaudeBot

Disallow: /

# Bloqueia o uso de dados para a Apple Intelligence

# (Não afeta a busca do Siri ou Spotlight)

User-agent: Applebot-Extended

Disallow: /Common Crawl

Muitos modelos de IA (incluindo versões antigas do GPT) são treinados com dados públicos do Common Crawl. Se você deseja máxima privacidade contra IAs futuras, considere bloquear este bot também:

User-agent: CCBot

Disallow: /Erros comuns e boas práticas

Configurar o robots.txt incorretamente pode prejudicar gravemente o seu SEO. Aqui estão os erros mais frequentes e como evitá-los:

1. Cuidado com a “Barra Final” (Trailing Slash)

Uma simples barra faz toda a diferença. O robots.txt interpreta os caminhos de forma literal.

- Disallow: /admin

- O que faz: Bloqueia qualquer URL que comece com “/admin”.

- Bloqueia: /admin/, /admin.php, /administracao-do-site.

- Disallow: /admin/

- O que faz: Bloqueia apenas o diretório e o que estiver dentro dele.

- Não bloqueia: /admin-login ou /administracao.

2. Não bloqueie arquivos CSS e JS

Antigamente, era comum bloquear pastas de estilos e scripts para “poupar” o bot. Hoje, isso é um erro grave.

O Googlebot precisa acessar arquivos .css e .js para renderizar a página como um usuário vê (verificar se é Mobile Friendly, por exemplo).

Se você bloqueá-los, o Google pode entender que seu site está quebrado ou não é otimizado.

3. Sensibilidade a Maiúsculas e Minúsculas (Case Sensitive)

O arquivo robots.txt diferencia letras.

- Disallow: /Arquivo/ não bloqueará /arquivo/.

- Certifique-se de que as regras correspondem exatamente à estrutura das URLs do seu site.

4. Ordem e Especificidade (Regra do Google)

Se houver conflito entre um Allow e um Disallow, o Google (e o Bing) segue a regra da diretiva mais longa (mais específica), e não necessariamente a ordem no arquivo.

Exemplo de Conflito:

User-agent: *

Disallow: /pasta/ (7 caracteres)

Allow: /pasta/arquivo.html (19 caracteres)Resultado: O Google vai rastrear o arquivo.html porque a regra Allow é mais longa (mais específica) que a regra Disallow, mesmo estando abaixo ou acima.

Sintaxe e Comandos

Os principais comandos são User-agent para especificar o bot e Disallow para especificar as páginas a serem bloqueadas. Você também pode usar Allow para permitir o acesso a páginas específicas.

Obs: O comando Allow não faz parte oficialmente das especificações do robots.txt, mas os principais mecanismos de busca o respeitam. No entanto, ele é redundante, pois tudo o que não é explicitamente bloqueado já está permitido para ser rastreado.

Aqui estão algumas das principais sintaxes e comandos que você pode usar em um arquivo robots.txt:

Comandos Básicos

- User-agent: Especifica o robô da web ao qual as regras se aplicam.

- Exemplo:

User-agent: Googlebot

- Exemplo:

- Disallow: Impede que robôs acessem determinadas partes do site.

- Exemplo:

Disallow: /privado/

- Exemplo:

- Allow: Permite que robôs acessem determinadas partes do site, mesmo que uma regra

Disallowmais ampla exista.- Exemplo:

Allow: /publico/

- Exemplo:

Sintaxes Básicas

- Coringa (*): Representa qualquer sequência de caracteres.

- Exemplo:

Disallow: /*.jpg$

- Exemplo:

- Dólar ($): Indica o fim de uma URL.

- Exemplo:

Disallow: /*.php$

- Exemplo:

- Comentários (#): Qualquer coisa após o símbolo

#em uma linha é um comentário.- Exemplo:

# Este é um comentário

- Exemplo:

- Sitemap: Fornece a localização do arquivo XML do sitemap.

- Exemplo:

Sitemap: http://www.exemplo.com/sitemap.xml

- Exemplo:

O robots.txt é obrigatório?

Ter um arquivo robots.txt não é obrigatório, mas é altamente recomendado para controlar o acesso dos bots e melhorar o SEO.

Ferramentas e Validadores

Existem várias ferramentas online, como o “Robots.txt Tester” do Google, que podem ajudá-lo a validar a sintaxe do seu arquivo.

Outros exemplos e modelos

Aqui estão alguns exemplos:

WordPress:

# Define as regras para todos os robôs de busca

User-Agent: *

# Não desabilita nenhum diretório ou arquivo, permitindo que todos sejam indexados

Disallow:

# Especifica o local do arquivo sitemap para ajudar os robôs a encontrar todas as páginas

Sitemap: https://www.exemplo.com/sitemap_index.xmlMagento:

User-agent: *

# Estes comandos impedirão que os robôs indexem os diretórios do sistema Magento

Disallow: /app/

Disallow: /bin/

Disallow: /dev/

Disallow: /lib/

Disallow: /phpserver/

Disallow: /pkginfo/

Disallow: /report/

Disallow: /setup/

Disallow: /update/

Disallow: /var/

Disallow: /vendor/

# Estes comandos impedirão que os robôs indexem arquivos do sistema presentes na raiz do Magento

Disallow: /composer.json

Disallow: /composer.lock

Disallow: /CONTRIBUTING.md

Disallow: /CONTRIBUTOR_LICENSE_AGREEMENT.html

Disallow: /COPYING.txt

Disallow: /Gruntfile.js

Disallow: /LICENSE.txt

Disallow: /LICENSE_AFL.txt

Disallow: /nginx.conf.sample

Disallow: /package.json

Disallow: /php.ini.sample

Disallow: /RELEASE_NOTES.txt

# Estes comandos impedirão que os robôs indexem URLs do sistema

Disallow: /index.php/

Disallow: /catalog/product_compare/

Disallow: /catalog/category/view/

Disallow: /catalog/product/view/

Disallow: /catalogsearch/

Disallow: /checkoutSegurança

É importante notar que o arquivo robots.txt não é uma medida de segurança. Informações sensíveis devem ser protegidas por outros métodos, como autenticação.

Conclusão

Em resumo, o arquivo robots.txt é uma ferramenta simples, mas poderosa, para gerenciar como os mecanismos de busca interagem com o seu site.

Ele permite que você especifique quais áreas do site devem ser acessíveis e quais devem ser mantidas fora do alcance.

Isso não apenas melhora a eficiência dos mecanismos de busca ao explorar seu site, mas também ajuda a manter informações que você não quer que sejam públicas fora do alcance dos bots.

Com um arquivo robots.txt bem configurado, você tem mais controle sobre a visibilidade do seu site na internet.

Publicado originalmente em 27/08/2023 | Última atualização em 13/01/2026